AI at school? Is it just there and do we have to deal with it?

Preliminary remarks for this english version

Although this article takes a critical look at the use of AI in schools, I have used an AI tool „made in Germany“ for the translation (https://www.deepl.com). it’s not my style and violates my idea of fluent english.

On the basis of these thoughts, I sometimes face strong criticism from the German education community or even the education administration for which I work – it seems to me, that I would break (male) technic toys or spoil them at least.

Introduction

Not a day goes by on social media without new, cool tips on using AI in the classroom. For three years now, I’ve been giving talks on AI to all kinds of groups and committees, which has increasingly turned into a very critical view of the topic.

1. AI applications that generate language prevent learning processes

Various researchers and experts point to serious shortcomings in language models, which form the backbone of many educational offerings. The effects on learning processes are also being described with increasing criticism. Significantly, the most nuanced criticism almost always comes from people with a background in computer science. Advocates of the use of language models in the teaching context always argue that it always depends on the type of use. I am not convinced of this.

As an example, I would like to refer to a recent study by Rainer Mühlhoff and Marte Henningsen, who took a closer look at a Fobizz tool for the automatic assessment of homework. There are several of these tools or offerings on the German market, even those that have received start-up awards. What they have in common is that they are based on the same IT technology and are explicitly aimed at teachers. The study’s base of data is relatively small – unfortunately, this is the case with many studies in the education sector. Here are some excerpts from the results:

- „Both the suggested overall grade and the qualitative feedback varied significantly between different assessment runs of the same submission. This volatility poses a serious problem, as teachers relying on the tool could unknowingly award ‘cherry-picked’ and potentially unfair grades and feedback.§

- „Even with full implementation of the suggestions for improvement, it was not possible to submit a “perfect” – i.e. no longer objectionable – submission. A near-perfect score was only achieved by revising the solution with ChatGPT, which signals to students that they need to rely on AI support to achieve a top score.“

- „The tool has fundamental shortcomings, several of which the study classifies as “fatal obstacles to use”. It is pointed out that most of the observed shortcomings are due to the inherent technical characteristics and limitations of large language models (LLMs). For these reasons, a quick technical solution to the shortcomings is not to be expected.“

The study refers to the use of language models by teachers. This should a use by experts with corresponding experience and expertise in the implementation of assessments.

The largely professionally unreflected demand for the nationwide provision of so-called AI tools can be found both in the press and in associations. Our media center actually provides teachers at schools run by the district with such access. I would now consider linking this provision to prior mandatory training and awareness-raising.

With regard to use by students, Jeppe Klitgaard Stricker has made some remarkable theses and observations for me:

- Intellectual mirroring (students unconsciously adopting AI speech patterns)

- Digital dependency disorder (students panic when AI tools are unavailable)

- The illusion of mastery (students thinking they understand because AI explained it)

- Collaborative intelligence decay (students abandoning human brainstorming when AI is faster)

- Reality-prompt confusion (students viewing real-life challenges as prompts to optimize)

- Knowledge confidence crisis (students doubting human wisdom vs AI certainty)

- AI-induced perfectionism (the pressure to match AI’s flawless outputs)

I would like to replace the word “students” with the word “learners” here, because many of the points are likely to apply to adults as well. This perspective is quite new to me, because up to now I have tended to take a cognitive-theoretical approach in my criticism of the use of language models in the classroom:

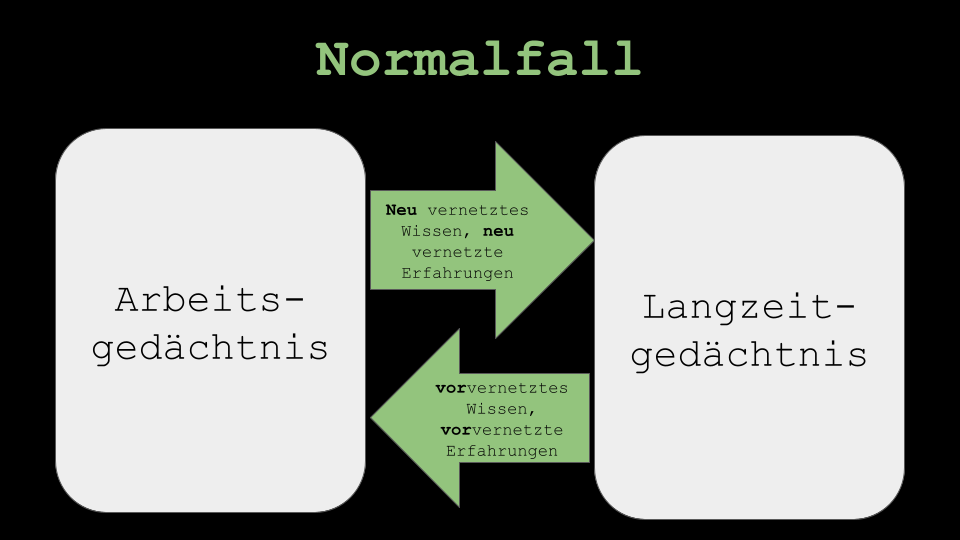

In a nutshell: Our working memory contains what we are currently thinking. Among other things, it is fed by what we have transferred to our long-term memory over the course of our lives. The degree of networking of this knowledge in long-term memory is greater for experienced people (experts) than for inexperienced people (novices). The output of language models overloads the capacity of the working memory of novices much faster than that of experts, because there is less compensation through pre-networked knowledge from long-term memory.

Of course, AI can be used at any stage, e.g. when writing seminar papers. However, the extent to which this makes sense for novices with a very heterogeneous degree of networking – which is how learning groups are composed – in long-term memory must be examined very carefully.

Taking into account the previous premises, language models can only be used to promote learning if the novices already have a certain amount of networked prior knowledge. For me, it would be irresponsible to focus teaching solely on the level of use and operation.

Experts, on the other hand, are probably much better at evaluating the output of language models, but without a basic understanding of their function, they cannot use them in a reflective manner. Who, for example, has the same text evaluated several times by an AI tool and then compares the outputs with each other, as was done in the study cited? What’s more, the marketing promise of time savings quickly becomes obsolete. Experts also tend to be „susceptible“ to the mechanisms formulated by Stricker.

2. Products of AI applications are the new plastic and contaminate the communication space of the Internet

Linux Lee, among others, came up with the idea of seeing generative AI products as analogous to plastic made from crude oil. Just as the petroleum product fills our tangible world, the products of generative AI (music, images, videos, texts, etc.) fill the communicative space of the internet.

In the course of sustainability thinking, plastic quickly falls into a negative corner, but as a material it is indispensable in many areas of modern society. One major difference is what can be done with existing plastic. In principle, plastic made from crude oil can be recycled, but this is neither economically viable nor are there any corresponding control mechanisms in the production and recycling chain that would make this possible. With a well-structured plastic cycle, multiple use of the material is conceivable in principle without any major loss of quality.

The more products of generative AI enter the communication space of the internet, the more likely it is that they themselves will become the actual training basis for AI. This is referred to as the „rebound effect“. More or less humorously, the thesis was formulated in relation to the education system that at some point a „teacher AI“ will evaluate the „AI homework“ of the students. Ironically, the study by Mühlhoff and Henningsen provides „initial evidence“ of precisely this. In contrast to plastic made from crude oil, the resource „product of a generative AI“ is not really limited if, for example, renewable energy is used to produce it. This means that there is no real interest or even a need to regulate these products. The critical view of AI in an educational context alone is definitely associated with hostility towards innovation.

This in turn has to do with the fact that AI is often not viewed in a differentiated way: Using similar computer science mechanisms, AI can generate language or calculate protein structures very efficiently in the development of medicines. These can become sustainable products, as is also possible with plastic made from crude oil. Both „are“ AI.

I would evaluate the latter use of AI very differently, as the resulting product is effective on a completely different level. I miss this difference in perspective in the social discussion. In the education sector in particular, the topic is usually saturated with marketing and buzzwords and usually reaches a target group that is not sufficiently educated in information technology.

Yes, what can you do? AI is here to stay!

… and doesn’t go away again. In my last graduation speech at my son’s school, I described how being able to choose is a luxury situation. In fact, you can choose not to use language models in class. Personally, I find it difficult to give longer text productions as homework – I prefer to do this in class, e.g. in combination with collaborative writing tools. The resulting products are already an independent achievement. An orthographic and grammatical „follow-up check“ using ki-based tools works very well. Especially in the intermediate level, the skills for evaluating „AI interventions“ in this area should, in principle, have already occurred in school life and be „pre-networked“ in long-term memory – actually.

One of the main tasks of education will be how to communicate that certain things should be mastered before AI is used – precisely because the machine can do it so much better. And not just for students, but above all for us teachers.

When we think about this, we very quickly end up with structural considerations about the german education system itself.

„Oh, Luise, stop … that’s too broad a field.“ (Theodor Fontane, Effi Briest, last sentence)